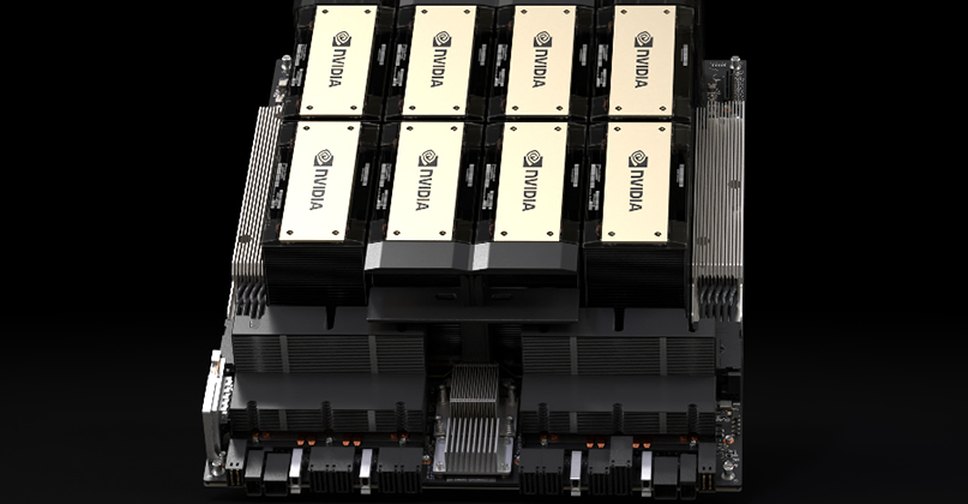

Η Nvidia αποκάλυψε το H200, μια μονάδα επεξεργασίας γραφικών που έχει σχεδιαστεί για εκπαίδευση και ανάπτυξη μοντέλων τεχνητής νοημοσύνης που ουσιαστικά τροφοδοτούν την έκρηξη της ζήτησης για δημιουργική τεχνητής νοημοσύνης.

Η νέα GPU είναι μια αναβάθμιση έκδοση του H100, το τσιπ που χρησιμοποιείται από την OpenAI για την εκπαίδευση του πιο προηγμένου μοντέλου μεγάλης γλώσσας, GPT-4. Τα τσιπ H100 κοστίζουν μεταξύ 25.000 και 40.000 δολαρίων, σύμφωνα με εκτίμηση της επενδυτικής τράπεζας Raymond James, και χιλιάδες από αυτά, συνεργαζόμενα μεταξύ τους, απαιτούνται για τη δημιουργία των μεγαλύτερων μοντέλων σε μια διαδικασία που ονομάζεται «εκπαίδευση».

Η Microsoft λανσάρει δύο νέα μικροτσίπ για AI και Cloud

Ο ενθουσιασμός για τις GPU AI της Nvidia έχει «υπερφορτώσει» τη μετοχή της εταιρείας, η οποία έχει αυξηθεί περισσότερο από 230% μέχρι στιγμής το 2023. Η Nvidia αναμένει έσοδα περίπου 16 δισεκατομμυρίων δολαρίων για το οικονομικό της τρίτο τρίμηνο, αυξημένα κατά 170% σε σχέση με την αντίστοιχη περυσινή περίοδο.

Η βασική βελτίωση που φέρνει το H200 είναι ότι περιλαμβάνει 141 GB μνήμης «HBM3» επόμενης γενιάς που θα βοηθήσει το τσιπ να εκτελέσει «συμπεράσματα» ή να χρησιμοποιήσει ένα μεγάλο μοντέλο αφού έχει εκπαιδευτεί να δημιουργεί κείμενο, εικόνες ή προβλέψεις.

Σύμφωνα με τα όσα ανακοίνωσε η Nvidia, το H200 θα παράγει αποτέλεσμα σχεδόν δύο φορές πιο γρήγορα από το H100. Το H200, αναμένεται να κυκλοφορήσει το δεύτερο τρίμηνο του 2024.

Η Nvidia είπε ότι το H200 θα είναι συμβατό με το H100, πράγμα που σημαίνει ότι οι εταιρείες τεχνητής νοημοσύνης που ήδη εκπαιδεύονται με το προηγούμενο μοντέλο δεν θα χρειαστεί να αλλάξουν τα συστήματα διακομιστή ή το λογισμικό τους για να χρησιμοποιήσουν τη νέα έκδοση.

Η Nvidia λέει ότι θα είναι διαθέσιμο σε διαμορφώσεις διακομιστών τεσσάρων ή οκτώ GPU στα ολοκληρωμένα συστήματα HGX της εταιρείας, καθώς και σε ένα τσιπ που ονομάζεται GH200, το οποίο συνδυάζει την GPU H200 με έναν επεξεργαστή βασισμένο σε αρχιτεκτονική Arm.

Πρωτοκαθεδρία για… λίγο

Ωστόσο, το H200 μπορεί να μην κρατήσει το στέμμα του ταχύτερου τσιπ AI για πολύ. Ενώ εταιρείες όπως η Nvidia προσφέρουν πολλές διαφορετικές διαμορφώσεις των τσιπ τους, οι νέοι ημιαγωγοί συχνά κάνουν ένα μεγάλο βήμα προς τα εμπρός περίπου κάθε δύο χρόνια, όταν οι κατασκευαστές μετακινούνται σε διαφορετική αρχιτεκτονική που ξεκλειδώνει πιο σημαντικά κέρδη απόδοσης από την προσθήκη μνήμης ή άλλων μικρότερων βελτιστοποιήσεων. Τόσο το H100 όσο και το H200 βασίζονται στην αρχιτεκτονική Hopper της Nvidia.

Τον Οκτώβριο, η Nvidia ανακοίνωσε στους επενδυτές ότι θα μετακινηθεί από έναν ρυθμό αρχιτεκτονικής δύο ετών σε ένα μοτίβο κυκλοφορίας ενός έτους λόγω της υψηλής ζήτησης για τις GPU της. Σύμφωνα με τον υπάρχοντα σχεδιασμό η εταιρεία πρόκειται να ανακοινώσει και να κυκλοφορήσει το τσιπ B100, που βασίζεται στην επερχόμενη αρχιτεκτονική Blackwell, το 2024.

Latest News

Η Google φέρνει στα ελληνικά σχολεία το “Experience AI”

Η Google και το Raspberry Pi Foundation παρέχουν χρηματοδοτική στήριξη και ενδυνάμωση σε εκπαιδευτικούς και μαθητές για ένα μέλλον καθοδηγούμενο από την Τεχνητή Νοημοσύνη

Σχέδιο απαγόρευσης των social media σε παιδιά κάτω των 15 ετών και στην Ελλάδα; - Τι εξετάζεται

Προωθούνται αυστηροί περιορισμοί στην πρόσβαση των παιδιών κάτω των 15 ετών στα social media

Πώς θα χτιστεί ο «Φάρος» του ελληνικού AI - Ο ρόλος του Υπερταμείου

Το έργο για τον «Φάρο» συνδέεται με την κατασκευή του εθνικού υπερυπολογιστή «Δαίδαλου» - Θα δημιουργηθεί θυγατρική που θα αναλάβει τη διαχείρισή του

Αποκαλυπτήρια για το «αλάνθαστο» κβαντικό μικροτσίπ της Google

Σε άρθρο που δημοσιεύθηκε στο περιοδικό Nature, η Google είπε ότι βρήκε έναν τρόπο να συνδυάζει τα Qubits του τσιπ Willow, έτσι ώστε τα ποσοστά σφαλμάτων να μειώνονται καθώς αυξάνεται ο αριθμός των Qubits

Δημιουργείται στην Ελλάδα το AI factory «Pharos» - Το μήνυμα Μητσοτάκη

«Η Ελλάδα μία από τις επτά χώρες της ΕΕ που θα δημιουργηθούν «εργοστάσια» τεχνητής νοημοσύνης τόνισε ο πρωθυπουργός

Πόση τεχνητή νοημοσύνη χρησιμοποιούν οι Έλληνες - Τι δείχνει έρευνα της Focus Bari

Στην έρευνα της Focus Bari αναλύονται οι ευκαιρίες, οι κίνδυνοι αλλά και οι μεγάλες προσδοκίες

Αυτές είναι οι χώρες με τα μεγαλύτερα ποσοστά online απάτης - Η θέση της Ελλάδας

Η έρευνα βασίζεται σε ένα σύνολο δεδομένων που περιλαμβάνει πάνω από 30.000 γνωστές απατηλές οντότητες, αναλύοντας τα μοτίβα αναζήτησης της Google σε περιεχόμενο της BrokerChooser σε 56 γλώσσες

Τι είναι η αβοκέτα... και οι υπόλοιπες κορυφαίες αναζητήσεις στην Google των Ελλήνων

Στις πιο δημοφιλείς αναζητήσεις των Ελλήνων στη μηχανή αναζήτησης της Google περιλαμβάνονται μεταξύ άλλων πρόσωπα μέχρι αθλήματα των Ολυμπιακών Αγώνων

Στο στόχαστρο των Βρυξελλών Google και Meta για «μυστικές διαφημίσεις»

Οι ρυθμιστικές αρχές ζητούν πληροφορίες για συνεργασία που παρακάμπτει τους κανόνες του γίγαντα αναζήτησης για ανηλίκους

Τα ρομποταξί της Tesla θα κινούνται με ανθρώπινο τηλεχειρισμό

Η Tesla σκοπεύει να ξεκινήσει την υπηρεσία ρομποταξί με έναν εταιρικό στόλο που υποστηρίζεται από εξ αποστάσεως τηλεχειρισμό

![Χειμερινή εξοχική κατοικία: Οι Ελληνες γυρνούν την πλάτη παρά την πτώση των τιμών [γραφήματα]](https://www.ot.gr/wp-content/uploads/2024/12/Capture-19-90x90.jpg)

Αριθμός Πιστοποίησης Μ.Η.Τ.232433

Αριθμός Πιστοποίησης Μ.Η.Τ.232433